« Le DataOps est une méthodologie collaborative de gestion des données dont l’objectif est d’améliorer la communication, l’intégration et l’automatisation des flux de données entre les gestionnaires et consommateurs de données au sein d’une organisation. »

Source : Gartner

Quels sont les défis auxquels répond le DataOps ?

Le DataOps est né en réponse aux trois défis majeurs auxquels font invariablement face les entreprises lançant des initiatives data :

Défi #1 – La cohésion entre les équipes

Les diverses parties prenantes telles que les équipes IT, Analytiques et Métiers travaillent principalement en silo, et leurs objectifs en termes de données et d’analytique peuvent différer. La plupart du temps, ils ont une culture différente, ce qui rend la cohésion difficile.

Défi #2 – L’efficacité des processus

La plupart des projets data et analytiques suivent une démarche artisanale et sont rarement déployés en production, gaspillant à la fois du temps et du budget pour les entreprises.

Défi #3 – La diversité des technologies

L’écosystème Big Data et IA est fragmenté, en constante évolution, avec une multitude de frameworks open source complexes à intégrer et à maintenir. Les organisations considèrent alors ces choix comme des investissements à hauts risques.

Quelles sont les conséquences de ces problématiques ?

- La valeur est dure à démontrer : Seulement 27% des CxO considèrent que leurs projets Big Data apportent de la valeur.

- L’implémentation est longue : On estime qu’il faut entre 12 et 18 mois pour concevoir et déployer des pilotes IA.

- Les projets sont rarement déployés en production : Seulement 50 % des projets IA lancés sont réellement déployés.

Quelle est l’approche proposée par le DataOps ?

Le DataOps offre une nouvelle approche des projets data basée sur deux méthodes bien connues : DevOps et Agile.

DevOps

Le DevOps est un ensemble de pratiques comblant le fossé existant entre les équipes de développement et opérationnelles, pour les faire travailler et itérer ensemble, tout au long des projets de développement logiciels.

Agile

La méthode Agile implique une multitude de procédés tels que la livraison en continu, le fail fast ou le test & learn pour rapidement déployer des cas d’usages en production, tout en encourageant la prise de confiance au sein des équipes.

Le DevOps est communément associé avec Agile, qui encourage des cycles de développement courts, un nombre important d’itérations et des déploiements plus fréquents. Le but de cette approche est de délivrer des logiciels de manière continue, en incluant les retours utilisateurs au cours du développement pour saisir davantage d’opportunités business.

Le DataOps partage les mêmes principes et les applique au traitement de données pour faciliter et accélérer la livraison d’analyses de données. En pratique, il s’appuie sur la combinaison d’équipes, d’outils et de processus uniques pour apporter agilité, orchestration et contrôle tout au long des projets. Un concept qui peut être révolutionnaire s’il est correctement adopté au sein des organisations.

Comment implémenter le DataOps ?

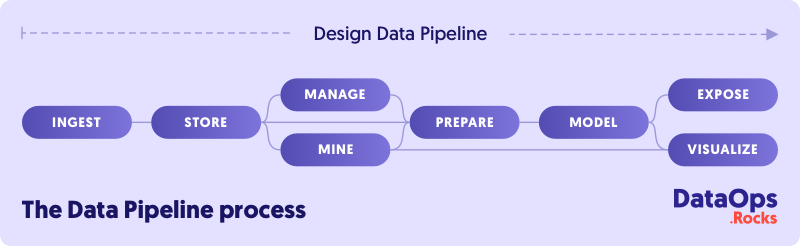

Dans le DataOps, plusieurs étapes se succèdent pour automatiser la conception, le déploiement et la gestion des flux de livraison de données. Cela doit se faire avec les niveaux appropriés de gouvernance et de métadonnées afin d’améliorer l’utilisation de la donnée et la valeur qu’elle génère dans un environnement dynamique.

Au cœur de ce processus se trouve un pipeline de données, qui désigne la succession d’étapes par lesquelles les données passent au cours d’un projet data. Il débute par l’extraction de données à partir de sources variées, jusqu’à leur exposition ou leur visualisation en vue d’une utilisation métier.

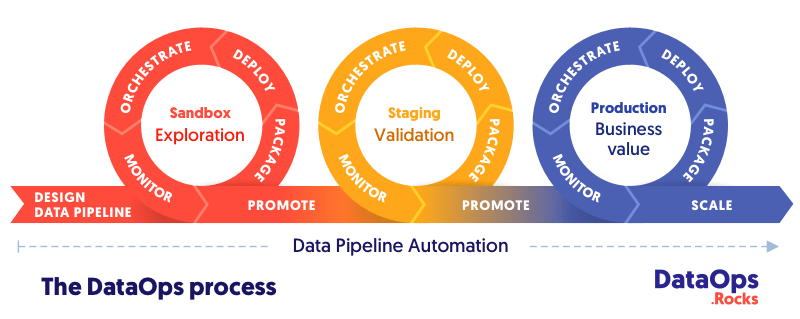

Le DataOps orchestre ce pipeline et l’automatise pour garantir sa bonne mise à l’échelle jusqu’en production, grâce à diverses pratiques de CI/CD. Ce processus complet peut être représenté par la succession de trois boucles, au sein desquelles les modèles de données sont promus entre environnements au terme de chaque étape, croissant en volume à mesure que de nouvelles données sont introduites dans le pipeline.

Boucle #1 – Sandbox

La donnée brute est explorée afin de réaliser de premières analyses encore peu raffinées. Cela permet aux équipes Data de faire preuve de créativité et de sonder toute valeur qui peut être tirée des données de l’organisation. Un nettoyage, un catalogage et une modélisation méticuleux de la donnée ne sont pas encore nécessaires, l’objectif principal ici étant l’expérimentation rapide plus que la démonstration de la fiabilité incontestable des modèles.

Boucle #2 – Staging

La donnée est nettoyée, documentée, et les premiers modèles sont affinés au travers d’itérations successives qui améliorent graduellement leur qualité. Ces modèles sont ensuite validés quand leur niveau de fiabilité est jugé suffisant pour la production.

Boucle #3 – Production

Enfin, les modèles analytiques sont promus vers un environnement de production pour y être exploités au quotidien par les consommateurs de données. Ceux-ci tirent alors parti de la connaissance dégagée pour accélérer les processus de décisions à l’échelle de l’entreprise et ainsi générer de la valeur métier et du ROI sur le long terme.

Quels sont ses bénéfices du DataOps ?

Il permet l’alignement des équipes pour créer de la valeur plus rapidement, grâce à une livraison des données de manière fluide.

Il améliore la qualité des données tout au long du pipeline de données pour garantir la fiabilité des modèles analytiques.

Il encourage la reproductibilité des travaux pour encore accélérer la création de valeur, en éliminant les tâches répétitives entre les différents projets.

Saagie & le DataOps

Saagie, éditeur d’une plateforme DataOps, propose une solution complète pour la gestion des projets data à partir d’une interface unique grâce à l’orchestration. Avec ses technologies prêtes à l’emploi et ses pipelines avancés, Saagie permet aux organisations de rationaliser leurs opérations data et de créer de la valeur métier. L’un des atouts majeurs de Saagie est son module complémentaire Data Apps Manager, qui permet l’intégration et le déploiement fluides d’applications Docker au sein des projets, offrant une gestion complète du cycle de vie des données, de l’extraction à la visualisation, en passant par le développement et le déploiement.

En tirant parti de la plateforme Saagie, les entreprises acquièrent un avantage concurrentiel dans le monde en constante évolution de la gestion des données. La possibilité d’assembler une multitude de technologies et de les orchestrer de manière transparente au sein de pipelines avancés apporte efficacité et agilité aux opérations data. L’interface unique de Saagie offre un point centralisé pour superviser l’ensemble des projets data, permettant aux équipes de collaborer efficacement et d’obtenir des résultats plus rapidement.

Testez Saagie gratuitement et explorez le monde du DataOps par vous-mêmes !